7月12日CAISP开班 | 安全人才短缺是企业AI市场最大瓶颈

AI在企业的部署速度远远低于预期,原因之一便是安全性难以保障。在高管尚未明确安全治理策略前,即便AI技术已具备商用潜力,生产化推进也极为艰难。

Chatterbox Labs的两位高管指出,当前AI部署比例不到10%,这与McKinsey预测的4万亿美元市场潜力形成鲜明反差。根本原因在于企业对AI的信任机制尚未建立,尤其是在安全测试与模型治理方面缺乏规范化体系。

在许多企业眼中,AI仍停留在“试点阶段”,即便初步取得业务价值,也很难迈过合规审查与安全审计的门槛。尤其是生成式AI,容易因输入输出不可控而引发数据泄露、误导性建议甚至法律风险,这些潜在后果使得大多数公司更倾向于“观望”,而非快速推进。正如Battersby所言,当前的内容过滤机制和guardrails远远不够,必须建立基于实际用途的、多层次的风险应对策略。

人才供给不足的问题再升级

随着AI系统结构与攻击面愈加复杂,企业面临的安全挑战也从传统网络层面跃升至模型层面,促使安全人才的稀缺愈发突出。调查显示,现有信息安全团队大多不具备AI领域的专业知识,而全球AI安全岗位空缺持续增加。高校供给滞后、企业招聘标准僵化,进一步加剧了结构性短缺问题,使得AI安全部署“心有余而力不足”。

企业需要的,不仅是熟悉防火墙和加密算法的传统安全专家,更需要能够识别提示注入、对抗样本攻击、隐私泄漏等AI特有威胁的新型“混合人才”。然而这类人才目前几乎无现成供给,许多岗位出现“高薪也难招”的尴尬局面。

根据ISC2的报告,2024年全球网络安全岗位缺口已达近500万人,其中AI安全领域更是供不应求。与此同时,AI专业背景的高校毕业生多偏重建模与算法实现,对安全机制与攻防测试往往缺乏系统训练,导致企业即使愿意培养,也难找到可塑性强的基础人才。

AI安全人才短缺带来的三重后果

AI安全人才短缺不仅造成部署缓慢,更会带来成本上升、风险叠加等连锁反应。一方面,缺乏合格人员让测试周期拉长,部署效率下降;另一方面,模型在无充分测试情况下被推向市场,可能埋下安全隐患。即便部署后,缺乏后续维护与红队机制,也让系统长期处于脆弱状态。企业既承担合规压力,又失去市场节奏。

此外,许多企业在缺乏内生安全能力的情况下,只能依赖第三方厂商来保障AI系统安全。但如Chatterbox所指出,模型供应商与guardrail(安全护栏)供应商往往过于强调“安全承诺”,而忽视了在具体业务场景中的实际表现。缺乏自有安全评估机制的企业,可能在不知情中使用了存在漏洞的AI服务,造成“信任外包”风险。更严重的是,一旦发生模型误用或滥用,如AI生成虚假内容被员工传播,责任归属模糊,法律与品牌影响巨大。

打破瓶颈:三条路径重构AI安全人才体系

解决安全人才瓶颈,需系统性变革:一是更新招聘逻辑,摒弃学历本位,鼓励基于技能和认证(例如CAISP)的开放筛选;二是构建校企政三方协作机制,推动AI安全专业化教育;三是用AI反哺安全流程,通过智能化工具减少对人力依赖,建立自动化防护与红队演练机制。这三条路径若协同发力,将显著缓解当前的人才与治理双重瓶颈。

企业首先要改变“唯学历论”的招聘文化,转向技能导向评估。AI安全领域需要的是真实理解模型行为、具备演练经验的人才,而非纸面上的硕士或博士文凭。同时,内部可设“安全转岗通道”,让原有IT、安全人员通过再培训和认证快速掌握基础AI知识,转型为“AI安全工程师”。此外,高校需增设与安全融合的AI课程,如“生成式AI治理”、“模型红队方法论”,为行业持续输送复合型人才。

政策层面也需加大支持,如国家层面设立“AI安全技术基金”,鼓励企业与高校联合开展攻防演练与标准建设。以欧洲为例,2025年起欧盟计划资助30家AI安全研究实验室,实施强制性AI系统风险评估制度,成为全球AI治理的先行者。中国也可探索设立“AI+安全联合实验室”机制,在科研项目中锻炼应用型安全人才。

安全是企业AI的核心竞争力

AI的未来不是技术孤岛,而是一场组织变革。唯有破解安全人才的结构性短缺,才能为AI生产化铺平道路。从招聘机制到人才培养,从测试机制到治理策略,安全能力的系统性建设,是AI市场从估值走向价值的必要条件。真正的竞争,不止于模型本身,而是构建谁能更安全、更可控地使用模型的能力。

正如Chatterbox Labs所强调:“别信任何厂商说它的模型永远安全。”企业要在AI新时代中赢得竞争,首先要建立自己的AI安全人才护城河。安全不是边缘问题,而是企业进入AI未来的“入场券”。

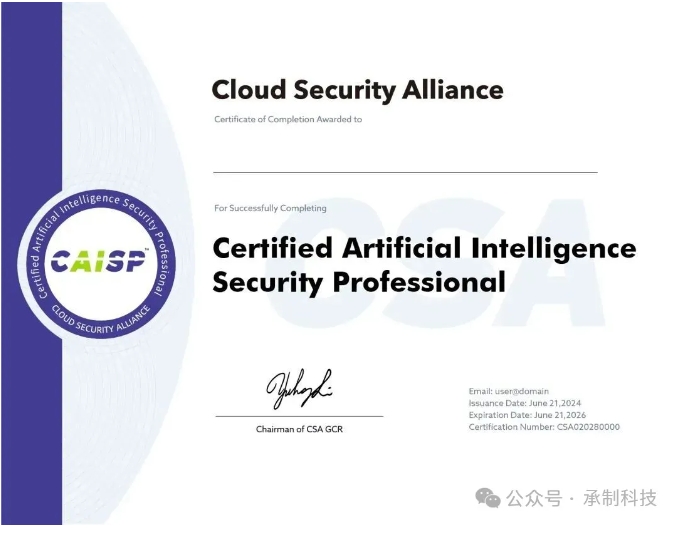

由CSA(国际云安全联盟)推出的人工智能安全认证专家课程内容全面覆盖技术细节、政策法规以及安全标准,并通过丰富的实践案例分析,确保学员能够深入掌握人工智能安全领域的专业知识。

CAISP

人工智能安全认证专家

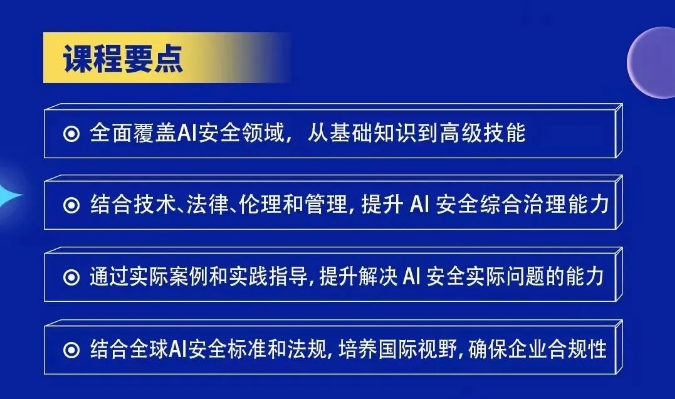

CAISP课程专注于理解人工智能安全的治理与管理环境,学习 AI 安全的术语与安全目标、针对于算法、模型以及数据安全和隐私进行学习,全面提升对 AI 安全风险的识别、评估与测评等实战化能力;课程还涵盖了 AI 安全的国内与国外的法律法规框架,并通过实际案例,探讨如何在组织中实施 AI 安全;此外,学员还将具体学习如何应对 AI 安全的风险与挑战,包括应对数据投毒、对抗性攻击和供应链威胁等多种安全挑战。

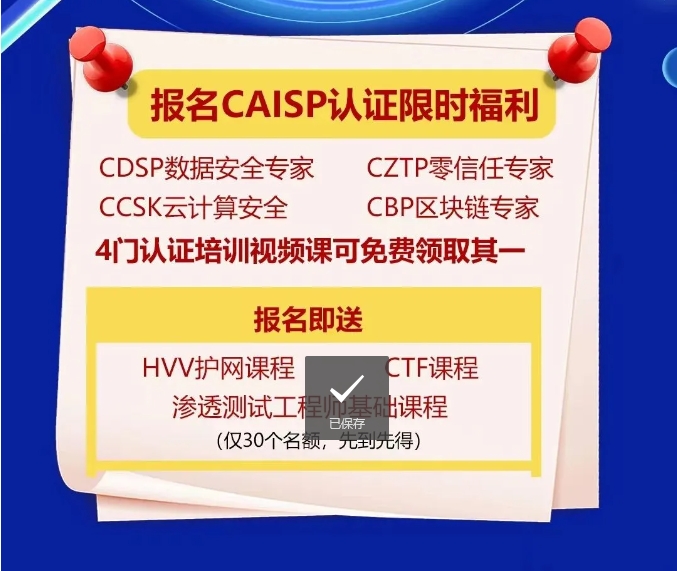

承制CAISP培训班

承制科技作为CSA授权培训机构,已成功举办了多期CAISP认证培训班,并且有不少学员已经申请并通过考试。

承制将继续提升CAISP教学服务质量,并将在7月12日举办下一期CAISP直播培训班,现在报名可提前进入预习阶段。

CAISP课程收益

对个人价值

- 技术与实战结合:通过实际案例和实践指导,提升解决实际问题的能力,将理论知识转化为实际操作技能,促进个人技术成长与实操经验积累。

- 国际视野拓展:结合全球AI安全标准和法规的学习,帮助个人形成国际化的视角,提升在跨国企业或国际合作项目中的适应性和价值。

- 法律法规精通:熟悉国内外政策法规,增强伦理道德意识,为个人职业生涯树立合规操作的基石,降低法律风险。

- 职业发展加速:获得CAISP认证,证明个人在AI安全领域的专业地位,有利于职业晋升、薪资增长以及更广泛的职业选择。

- 安全思维培养:从设计到运营的全周期安全管理能力,使得个人能够在任何涉及AI安全的项目中发挥关键作用,成为企业不可或缺的安全专家。

对企业价值

- 合规性保障:员工熟悉国内外AI安全政策和伦理道德,帮助企业建立合规的安全管理体系,避免法律风险,提升企业形象和社会责任感。

- 成本效率优化:通过DevSecOps的集成,提高AI开发流程的安全性与效率,减少因安全问题导致的修复成本和时间延误。

- 创新能力提升:在大语言模型安全实践与ChatGPT安全最佳实践的指导下,企业能够安全高效地利用最新技术,推动产品和服务创新。

- 安全化构建:培养员工在全生命周期的AI安全管理意识,形成以安全为导向的企业文化,为企业的可持续发展打下坚实基础。

- 竞争力增强:拥有具备CAISP认证的专家团队,企业能够在激烈的市场竞争中展现更高的安全标准和专业实力,吸引更多合作伙伴和客户信任。

CAISP学习对象

- AI行业相关人员:AI工程师与开发者、AI安全工程师、AI应用终端用户;

- 安全相关人员:安全研究员、合规与风险管理专员、网络安全从业者;

- 其他:政策制定者和监管机构、科技管理者、在校学生

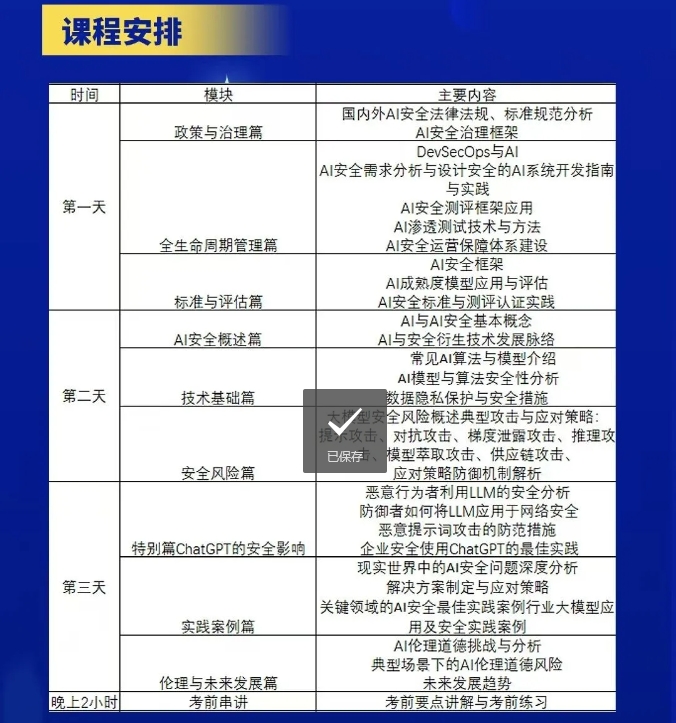

CAISP课程大纲

| 模块 | 培训内容 |

| AI安全概述篇 | AI与AI安全基本概念AI与安全衍生技术发展脉络 |

| 技术基础篇 | 常见AI算法与模型介绍AI模型与算法安全性分析数据隐私保护与安全措施 |

| 安全风险篇 | 大模型安全风险概述典型攻击与应对策略:提示攻击、对抗攻击、梯度泄露攻击、推理攻击、模型萃取攻击、供应链攻击、应对策略防御机制解析 |

| 政策与治理篇 | 国内外AI安全法律法规、标准规范分析AI安全治理框架 |

| 全生命周期管理篇 | DevSecOps与AIAI安全需求分析与设计安全的AI系统开发指南与实践AI安全测评框架应用AI渗透测试技术与方法AI安全运营保障体系建设 |

| 标准与评估篇 | AI安全框架AI成熟度模型应用与评估AI安全标准与测评认证实践 |

| 特别篇ChatGPT的安全影响 | 恶意行为者利用LLM的安全分析 防御者如何将LLM应用于网络安全恶意提示词攻击的防范措施 企业安全使用ChatGPT的最佳实践 |

| 实践案例篇 | 现实世界中的AI安全问题深度分析解决方案制定与应对策略关键领域的AI安全最佳实践案例行业大模型应用及安全实践案例 |

| 伦理与未来发展 | AI伦理道德挑战与分析典型场景下的AI伦理道德风险未来发展趋势 |

| 考前串讲 | 考前要点讲解与考前练习 |

CAISP证书样例